Se eu ganhasse um real para cada vez que alguém me perguntasse qual deve ser o tamanho amostral hoje eu estaria rico!!!

Isso se deve principalmente a uma falta de conhecimento de como os delineamentos amostrais são construídos.

No caso de planos amostrais vale a máxima:

"É melhor qualidade do que quantidade."

Ou seja, o tamanho amostral é importante mas não é mais importante do que a qualidade desse plano amostral. E a qualidade é medida pela variabilidade dos estimadores construídos, quanto menor a variabilidade maior a eficiência do plano amostral.

Essa variabilidade é alterada pelo tipo de delineamento amostral. Exemplos de desenhos amostrais são: amostragem aleatória simples, amostragem sistemática, amostragem por conglomerados, amostragem de Poisson, etc.

Entretanto, apesar da estimação da variância em planos amostrais e a construção de delineamentos sofisticados serem fundamentais, esses não serão escopo desse post.

Falarei aqui sobre como calcular o tamanho amostral para estimadores de proporção em amostras aleatórias simples.

Para outros tipos de estimadores, como: parâmetros de regressão, variância e correlações ou ainda estimadores em planos amostrais diferentes da amostra aleatória simples, outros textos são necessários (veja por exemplo: Cochran (1977); Schaeffer, et. al (2011), Särndal, et.al (2003)).

Cálculo do tamanho amostral para estimadores de proporção.

Para o cálculo do tamanho amostral necessário para estimar proporções alguns ingredientes são importantes:

- Tamanho da população: é o tamanho da população alvo. Representado usualmente por $N$

- Erro permissível: é o erro admitido para o estimador de proporção. Por exemplo, quando você assisti o Jornal Nacional e o William Bonner diz que o percentual de pessoas que aprovam o governo Dilma é de 68.4% com uma margem de erro de dois pontos percentuais para mais ou para menos (±2%), essa margem é o erro permissível. O tamanho amostral para a estimação de proporções leva em consideração o quanto você "aceita errar" na estimativa do parâmetro populacional. Para proporções esse erro deve estar entre 0 e 1 (varia entre 0% a 100%).

- Confiabilidade: como amostragem é um processo probabilístico, existe uma probabilidade desse erro permissível (ou seja o erro máximo aceitável) não ser satisfeito. Definimos como nível de confiança (confiabilidade) a probabilidade do erro máximo permissível ser satisfeito. Usualmente, trabalha-se com probabilidades como 90%, 95%, 99% ou ainda 99.9% dependendo do tipo de estudo. O nível de confiança (representado por $1-\alpha$ onde $\alpha$ é o nível crítico.) varia entre 0 e 1 (varia entre 0% a 100%)

- Proporção:o último ingrediente para o cálculo do tamanho amostral necessário é o valor da proporção representado por $\hat{p}$, esse valor varia entre 0 e 1 (varia entre 0% a 100%). Você deve ter pensado: "Mas pera aí... Como eu vou fornecer o valor da proporção para o cálculo do tamanho amostral se é JUSTAMENTE ISSO QUE EU QUERO ENCONTRAR ???". Você está certo em se indignar... Esse é o componente mais complicado de ser encontrado. Há no entanto algumas sugestões:

- Utilize $\hat{p}=0.5$. Nesse caso, o "pior dos casos" é construído e o tamanho amostral máximo é obtido. (Cochran (1977) página 72.)

- Encontre o valor de $\hat{p}$ utilizando outro estudo. Por exemplo, procure alguma estatística ou algum artigo que indique "mais ou menos" qual deve ser o valor da proporção. Suponha que o objetivo seja calcular a proporção de computadores quebrados na UnB, podemos usar algum texto ou artigo que estime a proporção de computadores em outra instituição de pesquisa e então essa proporção é utilizada como proxy.

- Faça uma amostra piloto utilizando um tamanho amostral arbitrário. Com base nessa amostra piloto calcule o valor da proporção e então estime o tamanho amostral necessário. Por exemplo, suponha que o objetivo seja, novamente, calcular a proporção de computadores quebrados na UnB. Podemos amostrar dez computadores e calcular o valor da proporção. Então utilizamos esse valor para estimar o tamanho da amostra. Suponha que encontremos o valor de 234 para o tamanho amostral. Isso significa que temos que amostrar 234 computadores... Mas, como dez computadores já foram amostrados, o tamanho da amostra deverá ser 224=234-10.

Podemos definir o erro permissível como 0.05, ou seja, adimite-se que a proporção de alunos que aprovam o uso de cotas no vestibular pode variar 5 pontos percentuais para mais ou para menos, o nível de confiança mais utilizado é de 95% isso significa que se o processo amostral for repetido muitas vezes espera-se que a margem de erro ±5% seja satisfeita em 95% das vezes. Por fim, como não conhecemos a priori nenhuma informação sobre o percentual de alunos que aprovam o uso de cotas, podemos fazer $\hat{p}=0.5$ como abordagem conservadora.

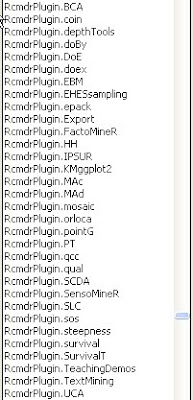

Abaixo segue o programa para o cálculo do tamanho amostral:

Note que ao executar o programa o tamanho da amostra estimado foi de 380. Esse valor poderia ser reduzido se fizéssemos uma amostra piloto ou se tivéssemos uma estimativa menos rígida para a proporção de alunos que aprovam o uso de cotas.

Maiores detalhes sobre esse processo, incluindo a fórmula para o cálculo do tamanho amostral você encontra em (Cochran (1977) página 75.)